Hammerspace Service Level Objectives | Hammerspace

目次

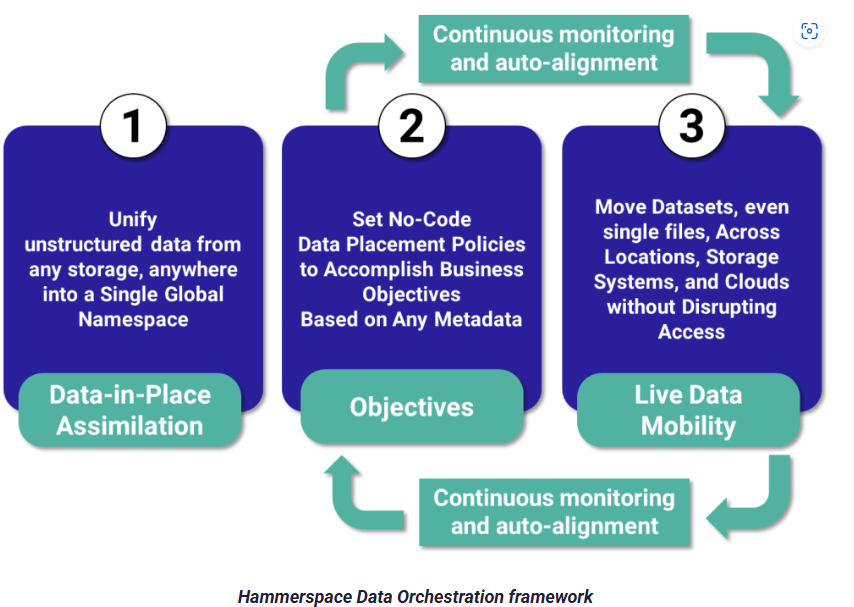

Data-in-place Assimilation

Objectives

Hammerspace Service Level Objectives | Hammerspace

Automating Data Management with Hammerspace Data Orchestration | Hammerspace

・Objectiveは事前に設定されたものと、smart-objectiveを自前につくることが可能。

・Smart-ObjectiveはCLIで作成。

smart-objective-create --name "Older than 90 days" --expression "IF LAST_USE_AGE<90*DAYS THEN {SLO('place-on-NAS')} ELSE {SLO('place-on-Amazon Web Services')}"・CLI/GUIでObjectiveを設定可能

Applying an Objective to a file

share-objective-add --objective "Older than 90 days" --name Engineering --path test.txt

Applying an Objective to a directory

share-objective-add --objective "Older than 90 days" --name Marketing --path /Projects

例:シェア、ファイル、ディレクトリをそれぞれアーカイブとして使いたい場合

以下のObjectiveを設定する。

- NAS Tier2

- 90日以上古い

- Virus scan

- WORM

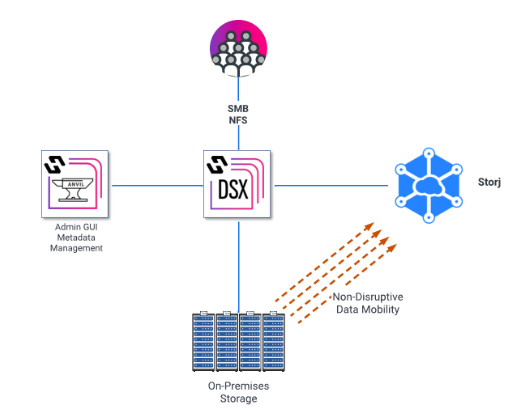

例:StorJクラウドをデータ格納先として使いたい場合

・オンプレの既存データをクラウドのStorj Cloudに無停止移行

・Storj Cloud(S3 I/F)をHammerspace配下に追加してボリューム(GFS配下ではない。)としてみせる

・Objectiveにplace-on-My-Storjを設定。ボリューム間の無停止移行(サイト間でも可能)

Leveraging Storj Distributed Cloud with Hammerspace Global File System | Hammerspace

例:その他

Welcome to DataCore vFilO Help

- Basic Tiering of Data from File Storage to Archive (Cloud/Object)

- Moving Snapshots to Cloud/Object Storage

- Keep Live on File Volumes

- Keep File Clones (Snapshots) on Cloud/Object Storage

- Place Files with Extension PDF on Cloud/Object Storage

- Move Data in the Archive Directory to Cloud/Object Storage

- Move Undelete Files to Cloud/Object Storage

オブジェクト

Technical_Brief_S3_Native_Object_Access_Meets_Parallel_File_System_Per.pdf

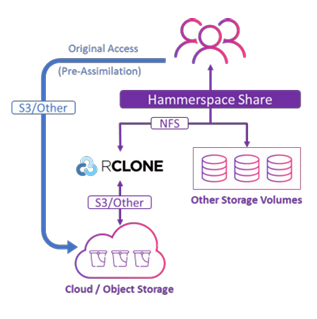

In-data Assimilation

Technical_Brief_Data_In_Place_Assimilation_Using_Hammerspace_and_Rclon.pdf

ユースケース①: Archive

・アーカイブデータをHammerspaceの配下にする

・Assimilation後はユーザはHammerspace経由でアーカイブデータにアクセス

・Writeは他のHammerspaceボリュームに書く

ユースケース②:Full migration

・フルマイグレーション

・Assimilationが始まった後はHammerspace経由のみでアクセス

RRDMA

Technical_Brief___Using_Hammerspace_with_RDMA.pdf

Mount NFS via RDMA on Mellanox Card | Sparktour’s Blog

・クライアント・DSXノードとDSXノード間でRDMA on RoCEv2 or InfiniBandが使用可能

・NVIDIA ConnectX-4以上が必要

・NFSのmountオプションに-o rdmaをつける

Tier0

http://A Detailed Analysis of Using Hammerspace Tier 0 for Checkpointing

Improve the Performance, Efficiency, and ROI of GPU Computing with Hammerspace Tier 0

Hammerspace MLPerf® Storage v1.0 Benchmark Results

<背景>

チェックポイントは定期的にアプリ状態を永続化する。

チェックポイント中はストレージ書き込み待ちになりGPUがアイドルになりやすい。

<Tier0>

- GPUサーバのローカルNVMeストレージをGFSの共有ストレージの上位Tierとして使用

- GPUサーバのローカルディスクをNFS v3 exportとして設定。GFSに組み入れる。クライアントはNFSv4.2のFlexFilesを使ってGFSをマウントすることでローカルディスクにアクセスする。

- Tier0はHammerspaceの保護ポリシで保護(例:GPUサーバノード間のミラーリング)

- Objectivesで新しいデータをTier0に古いデータを下位Tierに移動(どういうObjective?ファイル他員に手動?)

- ファイルをpinning

- Linuxのカーネルクライアントの性能改善。クライアントとサーバが同じホストにいた場合カーネルバイパス(Linux6.12より)。NFS LOCALIO — The Linux Kernel documentationと呼ばれる。

GFS

Hammerspace Multi-Cloud Data Sharing Demo

・ケース1:一つのサイトでアプリが動作し、データをハイブリッドクラウドで格納

ケース2:アプリがオンプレとクラウドで共有

- Objectiveでplace-on-premとplace-on-cloudの二つを指定。データをコピー。

Multis

Multi-Region Rendering with Deadline and Hammerspace | AWS for M&E Blog

Snapshot

Hammerspace Multi-Cloud Data Sharing Demo

・メタデータサーバがBlobを管理(17:00~くらい)